El brazo de investigación de Disney ofrece un nuevo método para comprimir imágenes, aprovechando el modelo de código abierto Stable Diffusion V1.2 para producir imágenes más realistas a velocidades de bits más bajas que los métodos de la competencia.

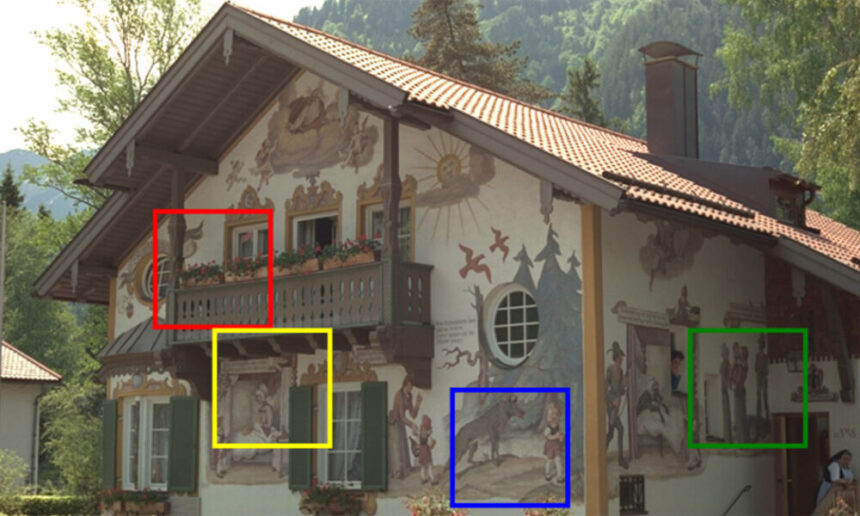

El método de compresión de Disney en comparación con enfoques anteriores. Los autores afirman haber mejorado la recuperación de detalles, al tiempo que ofrecen un modelo que no requiere cientos de miles de dólares de entrenamiento y que opera más rápido que el método competidor equivalente más cercano. Fuente: https://studios.disneyresearch.com/app/uploads/2024/09/Lossy-Image-Compression-with-Foundation-Diffusion-Models-Paper.pdf

El nuevo enfoque (definido como un ‘códec’ a pesar de su mayor complejidad en comparación con los códecs tradicionales como JPEG y AV1) puede funcionar sobre cualquier modelo de difusión latente (LDM). En pruebas cuantitativas, supera a los métodos anteriores en términos de precisión y detalle, y requiere significativamente menos capacitación y costos de computación.

La idea clave del nuevo trabajo es que error de cuantificación (un proceso central en toda compresión de imágenes) es similar a ruido (un proceso central en los modelos de difusión).

Por lo tanto, una imagen cuantificada “tradicionalmente” puede tratarse como una versión ruidosa de la imagen original y usarse en un proceso de eliminación de ruido de un LDM en lugar de ruido aleatorio, para reconstruir la imagen a una tasa de bits objetivo.

Más comparaciones del nuevo método de Disney (resaltado en verde), en comparación con enfoques rivales.

Los autores sostienen:

‘(Nosotros) formulamos la eliminación del error de cuantificación como una tarea de eliminación de ruido, utilizando la difusión para recuperar la información perdida en la imagen transmitida latente. Nuestro enfoque nos permite realizar menos del 10% del proceso generativo de difusión completo y no requiere cambios arquitectónicos en el modelo de difusión, lo que permite el uso de modelos de base como una base sólida sin ajustes adicionales de la columna vertebral.

“Nuestro códec propuesto supera a los métodos anteriores en métricas de realismo cuantitativo, y verificamos que nuestras reconstrucciones sean cualitativamente preferidas por los usuarios finales, incluso cuando otros métodos utilizan el doble de velocidad de bits”.

Sin embargo, al igual que otros proyectos que buscan explotar las capacidades de compresión de los modelos de difusión, el resultado puede alucinar detalles. Por el contrario, los métodos con pérdida como JPEG producirán áreas de detalle claramente distorsionadas o demasiado suavizadas, que el espectador ocasional puede reconocer como limitaciones de compresión.

En cambio, el códec de Disney puede alterar detalles del contexto que no estaban en la imagen de origen, debido a la naturaleza tosca del codificador automático variacional (VAE) utilizado en modelos típicos entrenados con datos de hiperescala.

«Al igual que otros enfoques generativos, nuestro método puede descartar ciertas características de la imagen mientras sintetiza información similar en el lado del receptor. Sin embargo, en casos específicos, esto podría dar como resultado una reconstrucción inexacta, como doblar líneas rectas o deformar los límites de objetos pequeños.

“Estos son problemas bien conocidos del modelo básico sobre el que construimos, que pueden atribuirse a la dimensión de características relativamente baja de su VAE”.

Si bien esto tiene algunas implicaciones para las representaciones artísticas y la verosimilitud de las fotografías casuales, podría tener un impacto más crítico en los casos en los que los pequeños detalles constituyen información esencial, como pruebas para casos judiciales, datos para el reconocimiento facial, escaneos para el reconocimiento óptico de caracteres (OCR). ), y una amplia variedad de otros posibles casos de uso, en caso de que se popularice un códec con esta capacidad.

En esta etapa incipiente del progreso de la compresión de imágenes mejorada por IA, todos estos escenarios posibles están muy lejos en el futuro. Sin embargo, el almacenamiento de imágenes es un desafío global a gran escala, que aborda cuestiones relacionadas con el almacenamiento de datos, la transmisión por secuencias y el consumo de electricidad, además de otras preocupaciones. Por lo tanto, la compresión basada en IA podría ofrecer un tentador equilibrio entre precisión y logística. La historia muestra que los mejores códecs no siempre obtienen la base de usuarios más amplia, cuando cuestiones como las licencias y la captura del mercado por parte de formatos propietarios son factores de adopción.

Disney lleva mucho tiempo experimentando con el aprendizaje automático como método de compresión. En 2020, uno de los investigadores del nuevo artículo participó en un proyecto basado en VAE para mejorar la compresión de vídeo.

El nuevo documento de Disney se actualizó a principios de octubre. Hoy la compañía lanzó un video de YouTube adjunto. El proyecto se titula Compresión de imágenes con pérdida con modelos de difusión de basey proviene de cuatro investigadores de ETH Zürich (afiliado a los proyectos basados en inteligencia artificial de Disney) y Disney Research. Los investigadores también ofrecen un artículo complementario.

Método

El nuevo método utiliza un VAE para codificar una imagen en su representación latente comprimida. En esta etapa, la imagen de entrada consta de características derivadas: representaciones vectoriales de bajo nivel. La incrustación latente luego se cuantifica nuevamente en un flujo de bits y nuevamente en el espacio de píxeles.

Esta imagen cuantificada se utiliza luego como plantilla para el ruido que generalmente genera una imagen basada en difusión, con un número variable de pasos de eliminación de ruido (donde a menudo existe un equilibrio entre mayores pasos de eliminación de ruido y mayor precisión, versus menor latencia y mayor eficiencia).

Esquema del nuevo método de compresión de Disney.

Tanto los parámetros de cuantificación como el número total de pasos de eliminación de ruido se pueden controlar con el nuevo sistema, mediante el entrenamiento de una red neuronal que predice las variables relevantes relacionadas con estos aspectos de la codificación. Este proceso se llama cuantización adaptativay el sistema de Disney utiliza el marco Entroformer como modelo de entropía que impulsa el procedimiento.

Los autores afirman:

‘Intuitivamente, nuestro método aprende a descartar información (mediante la transformación de cuantificación) que puede sintetizarse durante el proceso de difusión. Dado que los errores introducidos durante la cuantificación son similares a la suma (ruido) y los modelos de difusión son modelos funcionalmente de eliminación de ruido, se pueden utilizar para eliminar el ruido de cuantificación introducido durante la codificación.’

Stable Diffusion V2.1 es la columna vertebral de difusión del sistema, elegida porque la totalidad del código y los pesos base están disponibles públicamente. Sin embargo, los autores enfatizan que su esquema es aplicable a un número más amplio de modelos.

Fundamental para la economía del proceso es predicción de paso de tiempoque evalúa el número óptimo de pasos de eliminación de ruido: un acto de equilibrio entre eficiencia y rendimiento.

Predicciones de pasos de tiempo, con el número óptimo de pasos de eliminación de ruido indicados con un borde rojo. Consulte el PDF fuente para obtener una resolución precisa.

Es necesario considerar la cantidad de ruido en la incrustación latente al hacer una predicción para el mejor número de pasos de eliminación de ruido.

Datos y pruebas

El modelo fue entrenado en el conjunto de datos Vimeo-90k. Las imágenes se recortaron aleatoriamente a 256x256px para cada época (es decir, cada ingesta completa del conjunto de datos refinado por parte de la arquitectura de entrenamiento del modelo).

El modelo se optimizó para 300.000 pasos a una tasa de aprendizaje de 1e-4. Este es el valor más común entre los proyectos de visión por computadora, y también el valor más bajo y más detallado generalmente practicable, como un compromiso entre una amplia generalización de los conceptos y rasgos del conjunto de datos y la capacidad de reproducción de detalles finos.

Los autores comentan algunas de las consideraciones logísticas para un sistema económico pero eficaz*:

«Durante el entrenamiento, resulta prohibitivamente caro propagar hacia atrás el gradiente a través de múltiples pasadas del modelo de difusión mientras se ejecuta durante el muestreo DDIM. Por lo tanto, realizamos solo una iteración de muestreo DDIM y usamos directamente (esto) como (datos) completamente eliminados de ruido.’

Los conjuntos de datos utilizados para probar el sistema fueron Kodak; CLIC2022; y COCO 30k. El conjunto de datos se procesó previamente según la metodología descrita en la oferta de Google de 2023. Compresión de imágenes multirrealismo con un generador condicional.

Las métricas utilizadas fueron la relación señal-ruido máxima (PSNR); Métricas de similitud de percepción aprendida (LPIPS); Índice de Similitud Estructural Multiescala (MS-SSIM); y distancia de inicio de Fréchet (FID).

Los marcos rivales anteriores probados se dividieron entre sistemas más antiguos que utilizaban redes generativas adversas (GAN) y ofertas más recientes basadas en modelos de difusión. Los sistemas GAN probados fueron Compresión de imágenes generativas de alta fidelidad (HiFiC); e ILLM (que ofrece algunas mejoras en HiFiC).

Los sistemas basados en difusión fueron Compresión de imágenes con pérdida con modelos de difusión condicional (CDC) y Compresión de imágenes de alta fidelidad con modelos generativos basados en puntuaciones (HDF).

Resultados cuantitativos frente a marcos anteriores en varios conjuntos de datos.

Para los resultados cuantitativos (visualizados arriba), los investigadores afirman:

«Nuestro método establece un nuevo estado del arte en realismo de imágenes reconstruidas, superando todas las líneas de base en las curvas de tasa de bits FID. En algunas métricas de distorsión (a saber, LPIPS y MS-SSIM), superamos a todos los códecs basados en difusión y al mismo tiempo seguimos siendo competitivos con los códecs generativos de mayor rendimiento.

“Como era de esperar, nuestro método y otros métodos generativos sufren cuando se miden en PSNR, ya que favorecemos reconstrucciones perceptualmente agradables en lugar de una replicación exacta de los detalles”.

Para el estudio de usuarios, se utilizó un método de elección forzada de dos alternativas (2AFC), en un contexto de torneo donde las imágenes favoritas pasarían a rondas posteriores. El estudio utilizó el sistema de clasificación Elo desarrollado originalmente para torneos de ajedrez.

Por lo tanto, los participantes verían y seleccionarían lo mejor de dos imágenes presentadas de 512x512px a través de los distintos métodos generativos. Se llevó a cabo un experimento adicional en el que todo Se evaluaron comparaciones de imágenes del mismo usuario mediante una simulación de Monte Carlo de más de 10.0000 iteraciones, y la puntuación media se presentó en los resultados.

Calificaciones Elo estimadas para el estudio de usuarios, que incluyen torneos Elo para cada comparación (izquierda) y también para cada participante, con valores más altos, mejores.

Aquí los autores comentan:

‘Como puede verse en las puntuaciones Elo, nuestro método supera significativamente a todos los demás, incluso en comparación con el CDC, que utiliza en promedio el doble de bits que nuestro método. Esto sigue siendo cierto independientemente de la estrategia de torneo Elo utilizada.’

En el artículo original, así como en el PDF complementario, los autores proporcionan más comparaciones visuales, una de las cuales se muestra anteriormente en este artículo. Sin embargo, debido a la granularidad de la diferencia entre las muestras, remitimos al lector al PDF fuente, para que estos resultados puedan juzgarse de manera justa.

El artículo concluye señalando que el método propuesto funciona dos veces más rápido que el CDC rival (3,49 frente a 6,87 segundos, respectivamente). También observa que ILLM puede procesar una imagen en 0,27 segundos, pero que este sistema requiere un entrenamiento engorroso.

Conclusión

Los investigadores de ETH/Disney son claros, al concluir el artículo, sobre el potencial de su sistema para generar detalles falsos. Sin embargo, ninguna de las muestras ofrecidas en el material se centra en este tema.

Para ser justos, este problema no se limita al nuevo enfoque de Disney, sino que es un efecto colateral inevitable del uso de modelos de difusión –una arquitectura inventiva e interpretativa– para comprimir imágenes.

Curiosamente, hace sólo cinco días, otros dos investigadores de ETH Zurich publicaron un artículo titulado Alucinaciones condicionales para la compresión de imágenesque examina la posibilidad de un “nivel óptimo de alucinación” en los sistemas de compresión basados en IA.

Los autores defienden la conveniencia de las alucinaciones cuyo dominio sea lo suficientemente genérico (y, posiblemente, “inofensivo”):

‘Para contenido con textura, como hierba, pecas y paredes de piedra, generar píxeles que coincidan de manera realista con una textura determinada es más importante que reconstruir valores de píxeles precisos; generar cualquier muestra a partir de la distribución de una textura es generalmente suficiente.’

Por lo tanto, este segundo artículo defiende que la compresión sea óptimamente “creativa” y representativa, en lugar de recrear con la mayor precisión posible los rasgos y lineamientos centrales de la imagen original no comprimida.

Uno se pregunta qué haría la comunidad fotográfica y creativa con esta redefinición bastante radical de “compresión”.

*Mi conversión de las citas en línea de los autores a hipervínculos.

Publicado por primera vez el miércoles 30 de octubre de 2024