La intersección de la inteligencia artificial y la integridad académica ha llegado a un momento crucial con una decisión innovadora de un tribunal federal en Massachusetts. En el centro de este caso se encuentra una colisión entre la tecnología de inteligencia artificial emergente y los valores académicos tradicionales, centrada en el uso de las funciones de inteligencia artificial de Grammarly por parte de un estudiante de alto rendimiento para una tarea de historia.

El estudiante, con credenciales académicas excepcionales (incluido un puntaje SAT de 1520 y un puntaje perfecto en ACT), se encontró en el centro de una controversia sobre trampas de IA que en última instancia pondría a prueba los límites de la autoridad escolar en la era de la IA. Lo que comenzó como un proyecto del Día Nacional de la Historia se transformaría en una batalla legal que podría remodelar la forma en que las escuelas de todo Estados Unidos abordan el uso de la IA en la educación.

IA e integridad académica

El caso revela los complejos desafíos que enfrentan las escuelas en la asistencia de IA. El proyecto de Historia de Estados Unidos de AP del estudiante parecía sencillo: crear un guión documental sobre la leyenda del baloncesto Kareem Abdul-Jabbar. Sin embargo, la investigación reveló algo más complejo: el copiado y pegado directo de texto generado por IA, completo con citas de fuentes inexistentes como “Hoop Dreams: A Century of Basketball” de un “Robert Lee” ficticio.

Lo que hace que este caso sea particularmente significativo es cómo expone la naturaleza de múltiples capas de la deshonestidad académica moderna:

- Integración directa de IA: El estudiante usó Grammarly para generar contenido sin atribución

- Uso oculto: No se proporcionó ningún reconocimiento de la asistencia de AI

- Falsa autenticación: El trabajo incluía citas alucinadas por IA que daban una ilusión de investigación académica.

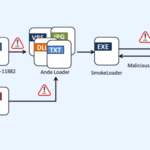

La respuesta de la escuela combinó métodos de detección tradicionales y modernos:

- Múltiples herramientas de detección de IA detectaron contenido potencial generado por máquinas

- La revisión del historial de revisión de documentos mostró que solo se dedicaron 52 minutos al documento, en comparación con las 7 a 9 horas de otros estudiantes.

- El análisis reveló citas de libros y autores inexistentes

Los análisis forenses digitales de la escuela revelaron que no se trataba de un caso de asistencia menor de la IA, sino más bien de un intento de hacer pasar el trabajo generado por la IA como una investigación original. Esta distinción sería crucial en el análisis del tribunal sobre si la respuesta de la escuela (calificaciones reprobatorias en dos componentes de la tarea y detención el sábado) fue apropiada.

Precedente legal e implicaciones

La decisión del tribunal en este caso podría afectar la forma en que los marcos legales se adaptan a las tecnologías de inteligencia artificial emergentes. El fallo no abordó solo un caso único de trampa por IA: estableció una base técnica sobre cómo las escuelas pueden abordar la detección y aplicación de la IA.

Los precedentes técnicos clave son sorprendentes:

- Las escuelas pueden confiar en múltiples métodos de detección, incluidas herramientas de software y análisis humanos.

- La detección de IA no requiere políticas explícitas de IA: los marcos de integridad académica existentes son suficientes

- La ciencia forense digital (como el seguimiento del tiempo dedicado a los documentos y el análisis de los historiales de revisión) son pruebas válidas

Esto es lo que hace que esto sea técnicamente importante: el tribunal validó un enfoque de detección híbrido que combina software de detección de IA, experiencia humana y principios tradicionales de integridad académica. Piense en ello como un sistema de seguridad de tres capas donde cada componente fortalece a los demás.

Detección y aplicación de la ley

La sofisticación técnica de los métodos de detección de la escuela merece especial atención. Emplearon lo que los expertos en seguridad reconocerían como un enfoque de autenticación multifactor para detectar el uso indebido de la IA:

Capa de detección primaria:

Verificación secundaria:

- Marcas de tiempo de creación de documentos

- Métricas de tiempo dedicado a la tarea

- Protocolos de verificación de citas

Lo que es particularmente interesante desde una perspectiva técnica es cómo la escuela cruzó estos puntos de datos. Al igual que un sistema de seguridad moderno no depende de un solo sensor, crearon una matriz de detección integral que hizo que el patrón de uso de la IA fuera inconfundible.

Por ejemplo, el tiempo de creación del documento de 52 minutos, combinado con citas alucinantes generadas por IA (el inexistente libro “Hoop Dreams”), creó una huella digital clara del uso no autorizado de IA. Es notablemente similar a cómo los expertos en ciberseguridad buscan múltiples indicadores de compromiso cuando investigan posibles infracciones.

El camino a seguir

Aquí es donde las implicaciones técnicas se vuelven realmente interesantes. La decisión del tribunal esencialmente valida lo que podríamos llamar un enfoque de “defensa en profundidad” de la integridad académica de la IA.

Pila de implementación técnica:

1. Sistemas de detección automatizados

- Reconocimiento de patrones de IA

- Forense digital

- Métricas de análisis de tiempo

2. Capa de supervisión humana

- Protocolos de revisión de expertos

- Análisis de contexto

- Patrones de interacción estudiantil

3. Marco de políticas

- Límites de uso claros

- Requisitos de documentación

- Protocolos de citación

Las políticas escolares más efectivas tratan la IA como cualquier otra herramienta poderosa: no se trata de prohibirla por completo, sino de establecer protocolos claros para su uso apropiado.

Piense en ello como implementar controles de acceso en un sistema seguro. Los estudiantes pueden utilizar herramientas de inteligencia artificial, pero deben:

- Declarar el uso por adelantado

- Documente su proceso

- Mantener la transparencia en todo

Remodelando la integridad académica en la era de la IA

Este fallo de Massachusetts es una visión fascinante de cómo evolucionará nuestro sistema educativo junto con la tecnología de inteligencia artificial.

Piense en este caso como la primera especificación del lenguaje de programación: establece la sintaxis central de cómo las escuelas y los estudiantes interactuarán con las herramientas de IA. ¿Las implicaciones? Son a la vez desafiantes y prometedores:

- Las escuelas necesitan sistemas de detección sofisticados, no solo soluciones de una sola herramienta

- El uso de la IA requiere vías de atribución claras, similares a la documentación del código

- Los marcos de integridad académica deben volverse “conscientes de la IA” sin volverse “fóbicos”

Lo que hace que esto sea particularmente fascinante desde una perspectiva técnica es que ya no estamos lidiando simplemente con escenarios binarios de “hacer trampa” versus “no hacer trampa”. La complejidad técnica de las herramientas de IA requiere marcos de políticas y detección matizados.

Las escuelas más exitosas probablemente tratarán la IA como cualquier otra herramienta académica poderosa: piense en las calculadoras gráficas en la clase de cálculo. No se trata de prohibir la tecnología, sino de definir protocolos claros para su uso adecuado.

Cada contribución académica necesita una atribución adecuada, documentación clara y procesos transparentes. Las escuelas que adopten esta mentalidad y al mismo tiempo mantengan rigurosos estándares de integridad prosperarán en la era de la IA. Este no es el fin de la integridad académica: es el comienzo de un enfoque más sofisticado para gestionar herramientas poderosas en la educación. Así como Git transformó la codificación colaborativa, los marcos de IA adecuados podrían transformar el aprendizaje colaborativo.

De cara al futuro, el mayor desafío no será detectar el uso de la IA, sino fomentar un entorno en el que los estudiantes aprendan a utilizar las herramientas de la IA de forma ética y eficaz. Ésa es la verdadera innovación que se esconde en este precedente legal.